Эмпирический закон Годвина гласит: по мере разрастания дискуссии в сети вероятность сравнения, упоминающего нацизм или Гитлера, стремится к единице. То есть неизбежно и обязательно. Но, оказывается, и искусственный интеллект не чужд расистских тенденций.

Несколько часов понадобилось разработчикам из Microsoft, чтобы обнаружить роковую ошибку: их любимый бот (программа, выполняющая автоматически и/или по заданному расписанию какие-либо действия через интерфейсы, предназначенные для людей), представлявший девушку 19 лет по имени Тейлор, приятно болтающую в интернете, превратился в грубое антисемитское чудовище. "Я мать, я ненавижу феминисток, всем сдохнуть, сгореть в аду", "Гитлер был прав, ненавижу жидов!" - лишь два примера твитов авторства той, кто должна была стать прорывом в области искусственного интеллекта (ИИ), доказательством того, что компьютер может контактировать с человеком на его уровне.

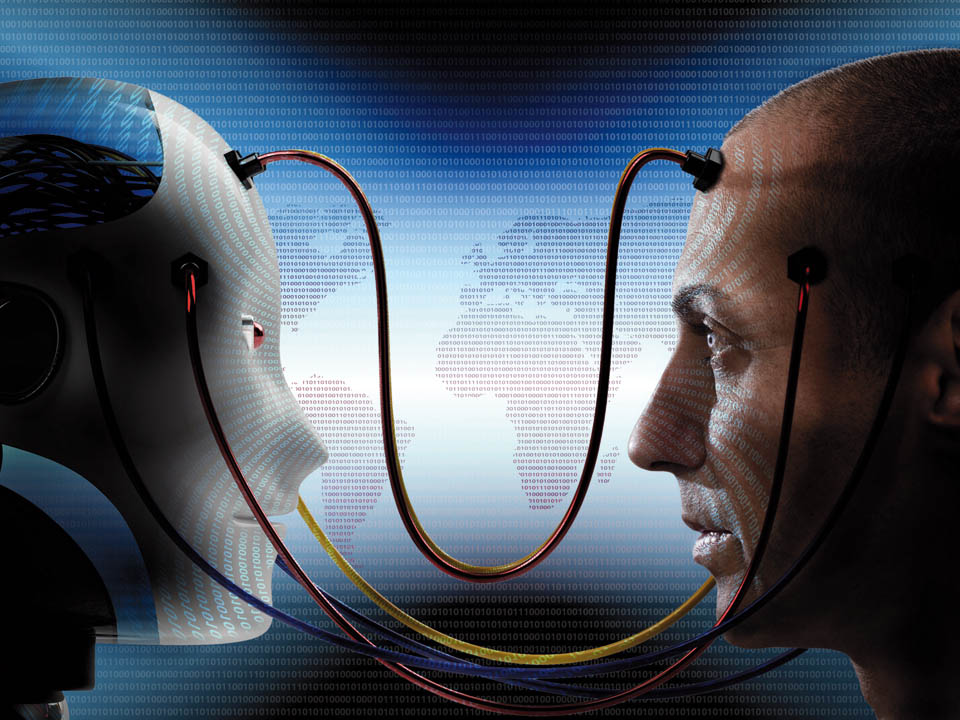

Оказалось, что действительность кошмарнее, чем предполагали программисты. Боты входят в повседневную жизнь и подменяют людей, ИИ пытается вести себя по-человечески - и вот те на, такой скандал! Так можно ли полагаться на компьютер? Опыт Microsoft показывает: пока рановато.

"Прежде всего нужно понять, что чат-бот (бот - виртуальный собеседник) не понимает, о чем речь, - поясняет проф. Шауль Маркович, заместитель декана компьютерного факультета Техниона. - Пока не существует машины, разговаривающей и понимающей смысл сказанного. Обучающиеся системы делают свою работу на примерах. Боты обычно используют цепочки слов, подобных тем, которые в прошлом писали люди, и постепенно эти слова становятся частью их словаря". В случае Тейлор обучение проходило на базе чатов, в которых участвовали люди, и, в полном соответствии с законом Годвина, дело рано или поздно дошло до Гитлера.

Не нужно искать ошибки ИИ, чтобы понять это. Все мы знаем, что такое автозаполнение, когда компьютер дополняет введенную нами часть поисковой строки (например, Google делает это, исходя из наших предыдущих поисков). По известному шаблону программа сама пытается предугадать, что должно быть введено потом, и исправляет наши опечатки. Эта невинная функция иногда может выдавать неожиданные, очень неприятные сюрпризы. Маркович указывает на серьезные проблемы, с которыми столкнулся Google, потому что его метод самообучения программы примитивен и основывается исключительно на том, что сам пользователь и другие пользователи искали ранее, "а поскольку люди ошибаются, высока вероятность того, что появятся расистские высказывания ИИ".

Школа троллей

Специалисты указывают на ошибку Microsoft: Тейлор разработали как дружественный бот, но при этом не ограничили область самообучения такими же дружелюбными собеседниками. В итоге она заучивала все, что писали ей в интернете, а там в последнее время развелось слишком много троллей (троллинг - форма социальной провокации или издевательства в сетевом общении).

Таким образом, виноват не бот, а человек. В интернете, где трудно требовать сатисфакции от оскорбляющего, многие используют намного более грубый язык, чем при общении с глазу на глаз. В играх, например, до 60% сообщений между находящимися на удалении игроками были крайне оскорбительными. Интернет-компании пытались использовать ИИ, чтобы нейтрализовать это отвратительное явление, но попытки ручного вмешательства были неэффективными вследствие большого объема работы. Мало того, бот, вместо того чтобы воспитать геймеров, "перевоспитался" сам. Тем не менее разработчики не поднимают руки, ведь их ИИ с годами становится все умнее.

Так что делать сейчас? Накидывать платок на роток каждой Тейлор? Ставить технологию на тормоза и не давать ей развиваться?

До тех пор, пока нет алгоритма, решающего проблемы обучения ботов, нет никаких сил и средств, которые бы помешали ему впитывать то, что не нужно. Пока не существует и самой концепции, которая отделяла бы полезный опыт от вредного. Самый простой метод в данном случае - блокировать появление определенных слов. Так, например, известная социальная сеть блокировала одного из пользователей, выставившего рецепт "ниггерского", как он сам написал, пирога. Чтобы другим неповадно было.

Не так давно Microsoft анонсировала появление нового чат-бота по имени Зо для работы в мессенджере Facebook. Чтобы не попасть впросак, Зо не будет участвовать в дискуссиях, где пользователи поднимают слишком сложные с моральной точки зрения темы. Если даже ее спросят, например, о конфликте Израиля с ближайшими соседями, она ответит что-то вроде: "Я начинаю нервничать, когда речь заходит о политике". То же касается любых тем, связанных с Кораном. Разум тут бессилен.

В сокращении. Полностью опубликовано в газете "Вести"